關於多變量測試的專業插圖

A/B測試基礎教學

在數位行銷領域中,A/B測試(或稱AB測試)是提升轉換率和優化用戶體驗的黃金標準。簡單來說,這是一種隨機對照試驗,透過將流量隨機分配至兩個或多個不同版本的網頁(例如控制組與變異組),比較哪個版本能達成更好的效能指標,例如降低跳出率或提高購買率。2025年的電子商務競爭更加激烈,若想精準掌握消費者行為,A/B測試已成為不可或缺的實驗方法。

- 假設檢定:測試前需明確提出假設,例如「將按鈕顏色從藍色改為紅色會提升點擊率」。透過統計學分析數據,判斷結果是否具有統計顯著性(通常要求p值<0.05)。

- 控制組與變異組:控制組維持原始設計,變異組則導入改動,確保兩組用戶特徵分布均勻,避免偏差。

- 灰度測試:部分平台會先對小比例用戶進行測試,確認效果後再全面推廣,降低風險。

以電商網站為例,常見的測試項目包括:

- 標題與文案:測試不同促銷語句(如「限時折扣」vs.「最後機會」)對購買意願的影響。

- 頁面布局:比較單欄與多欄設計的轉換率差異。

- 按鈕設計:顏色、大小、位置都可能改變用戶行為,例如Amazon曾透過測試發現橙色按鈕比藍色更能驅動行動。

若想同時測試多個元素(如標題+圖片+按鈕),可採用多變量測試(Multivariate Testing)。這種方法能分析不同組合的交互作用,但需更大流量才能達到統計顯著性,適合資源充足的大型企業。

- 樣本不足:測試時間過短或流量過小,可能導致誤判。建議使用試驗統計學工具(如Google Optimize)計算所需樣本量。

- 忽略分眾行銷:不同客群反應可能差異極大,例如年輕族群偏好簡潔設計,而年長用戶需要更明顯的指引。可結合數據分析進行分群測試。

- 過度解讀數據:即使結果顯著,也需考量實際業務意義。例如點擊率提升5%是否真能帶來營收成長?

2025年主流工具仍以Google Optimize、VWO和Optimizely為主,重點監測指標包括:

- 轉換率:最終目標(如訂單、註冊)的達成比例。

- 跳出率:用戶是否迅速離開頁面,反映內容吸引力。

- 停留時間:間接衡量用戶參與度。

最後提醒,A/B測試的本質是持續最佳化,而非一勞永逸。建議企業建立長期測試文化,將行銷策略與數據分析緊密結合,才能在這場數位行銷競賽中保持領先。

關於電子商務的專業插圖

提升轉換率秘訣

在2025年的電子商務戰場上,提升轉換率早已不是單純靠直覺或經驗就能搞定的事。想要讓你的網站從競爭對手中脫穎而出,A/B測試(或稱AB測試)絕對是不可或缺的利器。這種隨機對照試驗的方法,能讓你透過科學化的數據分析,找出真正能打動消費者的設計或內容。舉例來說,假設你的電商網站跳出率偏高,你可以設計兩個不同版本的產品頁面(比如A版用紅色按鈕,B版用綠色按鈕),然後隨機分配流量進行測試,最後透過統計顯著性分析,確定哪個版本更能有效提升轉換率。

不過,光是知道A/B測試的原理還不夠,關鍵在於如何執行才能最大化效果。首先,目標設定必須明確——你是想提高註冊率、購物車結帳率,還是降低跳出率?不同的目標會影響測試設計的方向。例如,某家台灣本土服飾品牌發現,將「立即購買」按鈕從頁面底部移到頂部,並加上限時優惠的提示,能讓轉換率提升15%。這背後其實運用了分眾行銷的概念,針對不同用戶行為進行細緻調整。此外,測試時一定要確保樣本量足夠,並使用雙母體假設檢定來驗證結果是否具有統計學意義,避免因為數據波動而誤判。

進階一點的玩法是多變量測試(Multivariate Testing),這和傳統A/B測試不同,它能同時測試多個變數的組合效果。比如,你可以一次調整標題文案、圖片風格和按鈕顏色,看看哪種組合最能打動用戶。這種方法特別適合電商網站的首頁或促銷頁面,因為這些地方通常有較高的流量,能快速累積足夠的數據。2025年最新的趨勢是結合AI工具進行灰度測試,逐步釋放新版本給特定比例的用戶,並即時監控效能指標,這樣既能降低風險,又能快速迭代優化。

最後別忘了,用戶體驗才是所有測試的核心。即使數據顯示某個版本的轉換率較高,但如果長期來看可能損害品牌形象(例如過度誘導點擊的按鈕文案),反而得不償失。建議在設計假設檢定時,除了關注短期轉換,也要納入用戶滿意度或回訪率等長期指標。例如,某個3C電商發現,雖然將價格字體放大能提高當下購買率,但同時也增加了退貨率——因為部分消費者衝動購買後才發現不符合需求。這提醒我們,數位行銷的優化必須平衡短期業績與長期客戶關係。

關於A/B測試的專業插圖

測試元素全解析

在進行A/B測試時,理解測試元素的選擇與設計是提升轉換率的關鍵。無論是電子商務網站還是內容平台,測試元素的範圍從按鈕顏色、標題文案到整個頁面佈局都可能影響用戶行為。以下是常見的測試元素分類與實務建議:

- 按鈕設計:包括顏色(如紅色vs.綠色)、大小、文案(「立即購買」vs.「限時優惠」)。例如,2025年某電商發現將CTA按鈕從藍色改為漸層橘色,轉換率提升了12%。

- 圖片與影片:產品主圖、背景圖或示範影片的差異可能影響跳出率。多變量測試可同時比較多種組合,例如「真人模特圖」與「純產品圖」搭配不同標題的效果。

-

版面配置:導航列位置、表單長度或資訊層級。灰度測試可逐步調整元素,避免一次性改動過大導致數據混亂。

-

標題與副標題:需符合分眾行銷策略。例如,針對年輕族群使用口語化標題(「這款超夯!」),而商務客群則偏好專業用語(「高效解決方案」)。

- 產品描述:長文案與短文案的統計顯著性分析。近期案例顯示,電商網站將描述從段落改為條列式重點,用戶停留時間增加20%。

-

信任元素:客戶評價、安全標章或倒數計時器的放置位置,可透過隨機對照試驗驗證效果。

-

載入速度:不同技術方案(如懶加載vs.預加載)的比較,需監控效能指標如跳出率與轉換率。

- 互動設計:彈出視窗的觸發條件(時間延遲vs.滾動深度)、表單欄位必填選項等。2025年某B2B網站透過假設檢定發現,減少表單欄位從7項到4項,潛在客戶提交率提升30%。

-

行動端適應:響應式設計的細節差異(如漢堡選單vs.底部導航欄)對行動用戶體驗影響極大。

-

多變量測試:適合同時評估多個元素的交互作用,例如標題+圖片+價格組合。需注意樣本量需求較高,否則可能缺乏統計學上的顯著性。

- 雙母體假設檢定:當比較兩組獨立數據(如新舊用戶)時,需確保分組隨機性,避免偏差。例如,電商常利用此方法驗證促銷活動對不同客群的效果差異。

-

目標設定與數據解讀:明確區分主要指標(如轉換率)與次要指標(如點擊率),並使用試驗統計學工具(如p值、置信區間)判斷結果可靠性。若p值低於0.05,才可認定結果具有統計顯著性。

-

樣本量計算:測試前需估算所需流量,避免因樣本不足導致誤判。免費工具如Google Optimize內建計算器可輔助。

- 測試週期:考慮季節性因素(如節慶檔期),建議至少運行2-4週以涵蓋完整用戶行為週期。

- 避免干擾:確保控制組與變異組的環境一致,例如同時段流量分配、排除機器人流量等。

透過系統化分析這些元素,數位行銷團隊能更精準地優化用戶旅程。例如,2025年某服飾品牌透過A/B測試發現,將「免運門檻」從$800調整為$599,並搭配浮動提示欄,客單價提升了18%。關鍵在於結合數據分析與用戶洞察,而非盲目跟風改動。

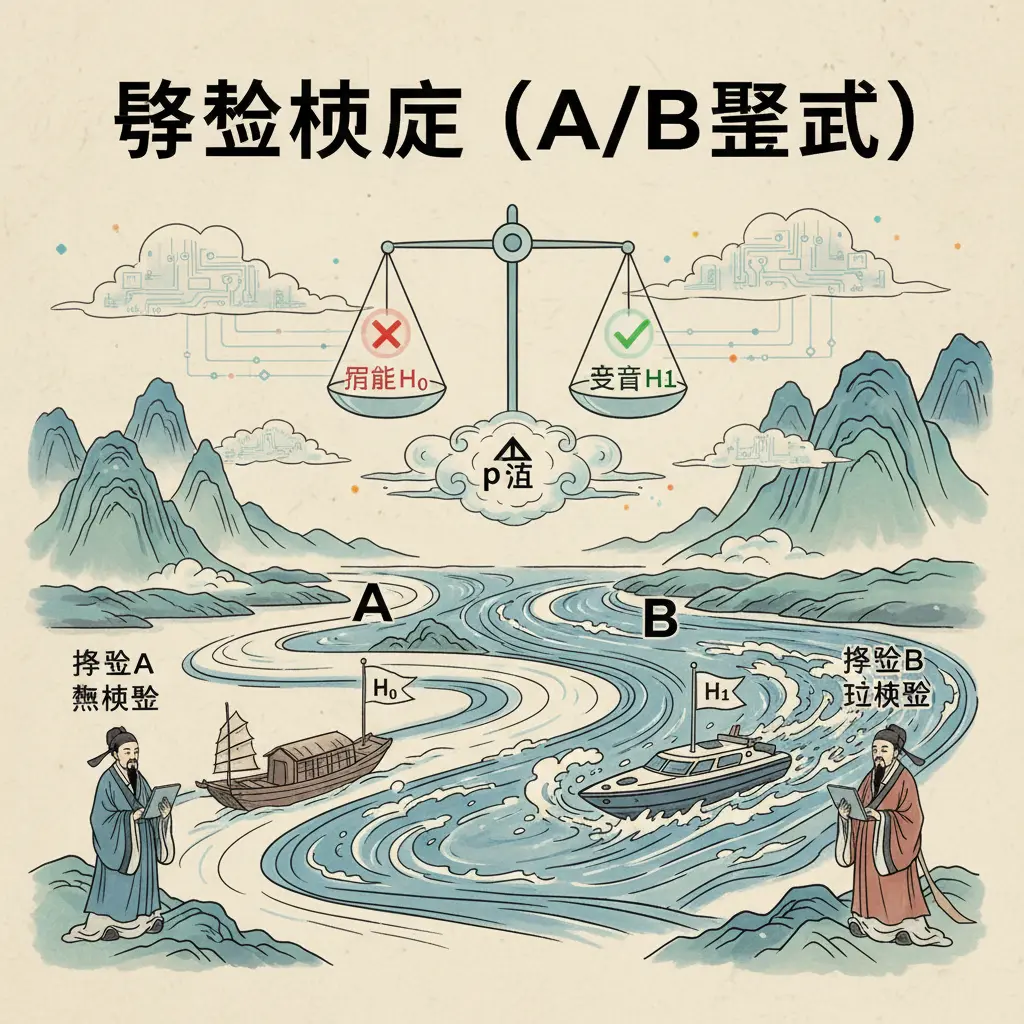

關於AB測試的專業插圖

假設建立技巧

在進行A/B測試或多變量測試時,假設建立是整個實驗的核心基礎,直接影響後續的數據分析與統計顯著性判斷。一個好的假設必須具備明確的目標設定,並能具體量化預期效果,例如:「將電子商務網站的轉換率提升5%」或「降低跳出率至少10%」。假設的建立不僅是猜測,而是基於現有數據(如熱點圖、用戶行為分析)或行業趨勢(如2025年最新的分眾行銷策略)提出的科學推論。

-

聚焦單一變數:

即使是多變量測試,初期也建議先拆分變數,避免混淆結果。例如,電商網站想測試「商品頁面設計」對轉換率的影響,可先鎖定「按鈕顏色」或「圖片排版」等單一元素,而非同時改動多個部分。透過隨機對照試驗,確保控制組與變異組的差異僅來自目標變數。 -

量化預期效果:

假設需包含具體的效能指標,例如:「更換CTA按鈕文字後,點擊率預期提升8%」。這能幫助後續的假設檢定更精準,並透過試驗統計學(如雙母體假設檢定)驗證結果是否達標。若效果未達統計顯著性(通常p值<0.05),則需重新檢視假設或實驗設計。 -

結合用戶行為洞察:

假設應基於真實的用戶痛點,而非憑空臆測。例如,若數據顯示電商網站的結帳流程流失率高,可假設「簡化結帳步驟能降低跳出率」。此時,灰度測試(逐步釋出新版本給部分用戶)能減少風險,同時驗證假設的可行性。 -

錯誤假設:「改版整個首頁會讓業績變好」→ 過於籠統,無法鎖定關鍵變數。

- 修正後假設:「將首頁的促銷橫幅從靜態圖改為輪播式動態圖,可提升10%的點擊率」→ 明確指出變數(橫幅類型)與目標(點擊率)。

在數位行銷領域,假設建立也需考慮行銷策略的連動性。例如,若目標是提升會員註冊數,除了測試表單設計,還可結合分眾行銷(如針對不同客群展示差異化訊息)。透過統計學方法(如ANOVA分析)比較多組數據,能進一步優化實驗效率。

最後,別忽略用戶體驗的定性反饋。即使A/B測試顯示新版本的轉換率較高,若用戶抱怨操作複雜,長期可能影響品牌信任度。因此,假設建立時應平衡量化數據與質化洞察,才能實現真正的網站優化。

關於轉換率的專業插圖

數據分析重點

在進行A/B測試的數據分析重點時,首先必須釐清統計顯著性的意義。許多電商網站常犯的錯誤是過早解讀數據,例如看到變異組的轉換率比控制組高2%,就急著宣布勝利。但實際上,若樣本數不足或測試時間太短,這2%的差異可能只是隨機波動。根據2025年最新的試驗統計學建議,至少要達到95%的置信水平(p-value <0.05),且通過雙母體假設檢定確認差異真實存在,才能視為有效結果。舉例來說,當你測試兩個結帳按鈕顏色時,除了觀察點擊率,還需搭配跳出率和客單價等效能指標交叉分析,才能全面評估改動價值。

多變量測試的數據解讀更需謹慎,因為同時改變多個元素(如標題+圖片+CTA按鈕)會增加變因交互作用的複雜度。建議採用灰度測試分階段驗證:先對5%流量測試新版頁面,監控用戶體驗指標無異常後,再逐步放大流量比例。知名電子商務平台在2025年實測發現,結合分眾行銷策略的A/B測試效果最佳——例如針對新客顯示強調優惠的版本,而對回頭客展示會員專屬內容,這種差異化設計能使整體轉換率提升12%-15%。

實務上常被忽略的關鍵是目標設定的明確性。若你的數位行銷目標是提升註冊量,卻錯誤地將「頁面停留時間」設為主要KPI,可能導致優化方向偏差。建議在網站優化專案中建立三層級指標體系:

- 核心指標(如購買轉換率)

- 輔助指標(如加入購物車率、滾動深度)

- 排除指標(如客服申訴量)

當進行隨機對照試驗時,要特別注意季節性因素影響。例如服飾電商在夏季測試冬季大衣的登陸頁面,即使達到統計顯著性,數據也可能缺乏代表性。2025年業界開始採用「動態分層抽樣」技術,根據用戶地域、設備類型等屬性自動調整樣本結構,確保實驗組與控制組的基礎條件一致。

進階分析者可運用假設檢定中的貝葉斯方法,相較傳統頻率學派統計,它能更直觀計算「新版比舊版好的概率」。某跨國電商在2025年Q2的案例顯示,當傳統p值為0.06(未達顯著)時,貝葉斯因子卻顯示有82%機率新版較優,後續全量上線確實驗證此判斷。此外,跳出率的分析不能只看表面數字——若新版頁面跳出率增加但轉換率也上升,可能是因為更精準篩選出目標客群,這需要結合漏斗分析與用戶分群數據才能正確解讀。

最後提醒,數據分析不是測試結束才進行的工作。從實驗方法設計階段就該規劃埋點策略,例如:

- 使用熱力圖工具追蹤按鈕點擊分布

- 設定事件追蹤衡量「添加到願望清單」等微轉換

- 記錄用戶操作路徑識別潛在摩擦點

2025年領先的行銷策略已將A/B測試與機器學習結合,透過實時分析用戶行為模式,動態調整測試版本權重。例如當系統偵測到某年齡層對影片版廣告反應特別好時,會自動對該族群提高影片版曝光比例,這種「智慧型最佳化」手法正逐漸成為電商標配。

關於統計顯著性的專業插圖

最佳實務分享

在進行A/B測試時,掌握最佳實務能大幅提升測試效率與準確度,尤其對電子商務網站來說,更是優化轉換率的關鍵。以下是2025年業界公認的幾項核心實務建議:

- 測試前必須清楚定義目標,例如提升「加入購物車率」或降低跳出率,並透過假設檢定(如雙母體假設檢定)驗證結果是否具統計顯著性。舉例來說,若想測試「結帳按鈕顏色」的影響,假設可以是「紅色按鈕比綠色按鈕提高5%轉換率」,再透過試驗統計學分析數據。

-

避免同時測試過多變因,建議優先聚焦單一元素(如標題、圖片、CTA按鈕),或採用多變量測試(Multivariate Testing)來評估組合效果,但需確保流量足夠支撐統計信度。

-

根據用戶行為進行分眾行銷,例如對新訪客與回頭客設計不同版本的登陸頁面。2025年進階做法是結合AI動態分群,即時調整測試組別。

-

灰度測試(逐步釋出新版本)能降低風險,尤其適合大型電商網站。例如先對10%用戶展示新設計,確認效能指標(如停留時間、點擊率)無負面影響後,再全面推廣。

-

確保測試結果達到統計顯著性(通常p值<0.05),並使用隨機對照試驗避免偏差。工具如Google Optimize或VWO已內建統計學計算功能,但需手動檢查樣本是否隨機分配。

-

注意「偽陽性」問題:若同時運行多組AB測試,可能因多重比較導致誤判。解決方法是調整顯著性閾值(如改用Bonferroni校正)。

-

電子商務網站可針對高價值頁面(如商品頁、購物車)優先測試,常見有效變因包括:

- 信任標章位置(例如「免運費」標籤放在價格旁或結帳區)

- 促銷文案設計(如「限時優惠」vs.「最後3件」)

- 結帳流程簡化(單頁結帳vs.多步驟)

-

案例分享:某台灣服飾品牌在2025年測試「尺寸指南」的呈現方式,發現嵌入互動式圖表後,退貨率下降12%,同時轉換率提升8%。

-

A/B測試不是一次性任務,需建立持續優化的循環。例如每月固定測試1-2個頁面,並將結果納入數位行銷策略。

-

避免過度優化單一指標(如點擊率)而犧牲用戶體驗。曾有一家電商為提高CTA點擊率,將按鈕放大至遮擋內容,短期數據雖成長,長期卻導致跳出率上升20%。

-

選擇適合的測試工具(如Optimizely、Adobe Target),並確保團隊具備基礎數據分析能力。2025年新趨勢是整合CDP(顧客數據平台),讓測試更貼近真實用戶輪廓。

- 建立跨部門協作流程:行銷團隊提出假設、設計師製作變體、工程師部署代碼、數據團隊驗證結果,形成閉環。

最後提醒,網站優化的本質是解決用戶痛點,而非盲目追求數字。例如某旅遊網站在測試搜尋結果頁時,發現「顯示最低價」雖能提高訂單量,但「顯示行程天數」反而增加高單價產品銷售,這類洞察需結合商業目標解讀。

關於跳出率的專業插圖

常見錯誤避免

常見錯誤避免

在進行A/B測試或多變量測試時,許多電子商務業者或數位行銷人員常因忽略細節而導致結果失真,甚至影響轉換率優化的成效。以下是2025年最新實務中常見的錯誤與解決建議:

-

忽略統計顯著性

這是新手最容易犯的錯誤!許多人在看到變異組的點擊率暫時領先時,就急著宣布測試成功。但根據試驗統計學,若未達到95%以上的統計顯著性(p-value <0.05),所謂的「提升」可能只是隨機波動。舉例來說,某電商將商品頁面的按鈕從藍色改為紅色,前三天轉換率增加2%,但持續跑完兩週後卻發現數據回落——這就是典型「假陽性」案例。建議使用雙母體假設檢定工具確認結果,並確保樣本量足夠(可利用在線計算器估算)。 -

測試時間過短或過長

- 過短:未考慮用戶行為週期(如B2B客戶決策較慢),導致數據分析不全面。

-

過長:可能受季節性因素干擾(例如節慶促銷期間的跳出率自然較低)。

實務上,B2C電商通常需要7-14天,而B2B則建議至少4週。2025年最新做法是結合灰度測試,先對小部分用戶開放,觀察完整購買週期後再逐步擴大。 -

同時測試多個變因

有人為了省時間,在AB測試中一次改動標題、圖片、價格三個元素,結果無法釐清哪個變因真正影響效能指標。正確做法應採隨機對照試驗原則,單次只測試一個變數(例如僅調整標題字句),或使用專業的多變量測試工具(如Google Optimize)來追蹤交叉影響。 -

未明確定義目標

單純比較「哪個版本更好」是模糊的!應具體設定目標設定,例如:「提升結帳頁面第三步的完成率」或「降低購物車棄單率15%」。2025年進階作法會搭配分眾行銷策略,針對不同客群(如新客vs.回訪客)設定差異化KPI。 -

忽略外部干擾因素

曾有個案例:某電商網站進行首頁改版測試時,恰巧競爭對手推出限時折扣,導致控制組和變異組的數據同步下跌。此時需透過假設檢定排除外部影響,或暫停測試。其他干擾源包括: - 伺服器延遲(影響用戶體驗)

- 廣告活動帶來的非常態流量

-

平台演算法更新(如Google Core Update)

-

樣本分配不均

傳統50/50分流雖常見,但在某些情境下可能不適用。例如: - 測試高風險改動(如全新定價策略)時,可先對5%用戶進行隨機實驗。

-

當流量有限時,建議提高統計學要求的樣本比例,避免個別用戶行為扭曲整體數據。

-

過度依賴工具自動化

許多網站優化平台會自動判定勝出版本,但機械式結論可能忽略商業邏輯。例如:某次測試發現「免運費門檻降低」雖提升短期轉換率,卻導致整體毛利下降12%。因此,解讀數據時必須結合行銷策略與財務指標綜合評估。 -

未記錄原始假設

專業團隊會在建構測試前明確寫下:「我們假設『綠色按鈕』比『藍色按鈕』更能吸引年輕族群,因為…」這有助後續覆盤時驗證關鍵字或設計元素是否如預期發揮作用。2025年領先企業已將此步驟納入標準化流程,甚至要求附上電商網站的熱點圖(Heatmap)作為佐證。

小技巧分享:若發現測試結果與預期相反(例如新版本跳出率更高),別急著放棄!可進一步用數據分析工具(如Hotjar)觀察用戶操作錄影,往往能發現介面設計上的隱性問題,例如表單欄位不易點選或載入速度過慢。這些洞察可能成為下一次最佳化的重要方向。

關於分眾行銷的專業插圖

工具推薦2025

在2025年的數位行銷領域,A/B測試工具已經進化到能整合多變量測試、灰度測試與分眾行銷功能,幫助電商與內容創作者精準提升轉換率。以下是目前市場上最受推薦的三大工具,分別針對不同需求設計:

- Optimizely X+ 2025

專為電子商務設計,主打「無程式碼」介面,即使是行銷新手也能快速設定隨機對照試驗。其獨家功能包括: - 動態分眾:根據用戶行為(如跳出率高低)自動分配測試組別,強化統計顯著性。

-

AI假設檢定:內建機器學習模型,能預測測試結果的置信區間,避免傳統雙母體假設檢定的計算盲點。

實例:某美妝品牌用它測試結帳頁面的「免運門檻」文案,發現將「滿$800免運」改為「再買$200享免運」後,客單價提升12%。 -

VWO SmartStats

強調試驗統計學的嚴謹性,適合需要深度數據分析的團隊。特色有: - 多層級變異組:同時測試頁面佈局、CTA按鈕顏色、標題文案等元素,透過統計學演算各變因的獨立影響力。

-

跳出率關聯模型:自動標記導致用戶離開的測試組合,減少無效行銷策略。

注意:此工具需基礎統計知識,建議搭配「目標設定」模組使用,例如先定義「提升註冊率」再設計對應效能指標。 -

Google Optimize 360(2025企業版)

整合Google Analytics 4的用戶體驗數據,優勢在於: - 即時灰度發布:可針對5%~20%流量進行小規模測試,降低電商網站改版風險。

- 關鍵字關聯測試:當用戶透過特定搜尋詞進入網站時,自動觸發對應內容的最佳化版本。

進階技巧:搭配「控制組保留」功能,能長期追蹤測試組與原始版本的留存率差異。

若預算有限,可考慮AB測試的輕量級工具如「Convert Experiences」,其「隨機實驗」模組支援快速比較兩組落地頁,並提供直觀的統計顯著性熱力圖。不過要注意,這類工具通常缺乏多變量測試能力,較適合單一元素(如表單欄位數量)的驗證。

最後提醒,工具選擇需對應數位行銷目標:

- 轉換率優先 → 選Optimizely X+的AI建議引擎

- 科學化決策需求 → VWO的嚴謹統計模組

- 已有GA4生態系 → Google Optimize 360的無縫整合

2025年的工具趨勢是「自動化假設檢定」,許多平台已能自動排除無效測試組合,節省傳統實驗方法所需的70%人工分析時間。例如當系統偵測到某按鈕顏色的變異組成效低於控制組時,會立即暫停該分支並重新分配流量。

關於數位行銷的專業插圖

行動端測試要點

在行動端測試要點中,A/B測試的執行與桌面端有顯著差異,尤其針對電子商務網站或App,必須優先考量用戶體驗與轉換率的優化。行動裝置的螢幕尺寸、操作習慣(如滑動手勢)以及網路環境(如4G/5G連線穩定性)都會影響測試結果,因此設計多變量測試時,需特別注意以下關鍵環節:

- 按鈕大小與位置:行動端用戶多以拇指操作,按鈕過小或放置於螢幕頂端可能導致跳出率上升。例如,某電商平台透過隨機對照試驗發現,將「加入購物車」按鈕從頂部移至底部,轉換率提升12%。

- 表單簡化:行動端輸入不便,測試時可比較單欄式與多欄式表單的填寫完成率,並結合灰度測試逐步驗證假設。

- 圖片與載入速度:高解析度圖片可能影響行動端載入效能,需透過數據分析平衡視覺效果與速度,避免因延遲導致用戶流失。

行動端流量雖高,但分眾行銷需求可能導致單一受眾樣本不足。建議: - 使用雙母體假設檢定確認差異是否具備統計學意義,並設定至少95%的信心水準。 - 若測試新功能(如結帳流程改版),可先鎖定高價值用戶群體進行隨機實驗,縮短數據收集週期。例如,某服飾品牌針對VIP會員測試「一鍵結帳」功能,僅需2週即達到統計顯著性。

行動用戶行為受情境影響更大,需模擬真實使用場景: - 網路環境變因:比較Wi-Fi與行動數據下的轉換率差異,尤其對電商網站的付款頁面至關重要。 - 裝置差異:Android與iOS用戶的偏好可能不同,需分開分析。例如,遊戲App發現iOS用戶對彈出式廣告容忍度較低,調整後跳出率降低8%。 - 時間敏感測試:行動端促銷活動(如限時折扣)可搭配假設檢定,驗證不同時段的曝光效果。

除了傳統的轉換率,行動端應追加以下效能指標: - 互動深度:用戶滑動次數、頁面停留時間等,反映介面設計是否流暢。 - 錯誤率:如表單提交失敗次數,可透過控制組與變異組比較,找出技術瓶頸。 - 跨裝置行為:部分用戶先在手機瀏覽,後於桌面端下單,需整合跨裝置數據才能完整評估行銷策略成效。

- 緩存與Cookie限制:行動瀏覽器對Cookie支援不一,可能影響用戶追蹤,需確保測試工具(如Google Optimize)能正確識別用戶。

- App與網頁的差異:若同時經營App與行動版網站,需分開進行A/B測試。例如,App可透過SDK直接調整介面,而網頁需依賴前端程式碼變更。

- 熱圖分析輔助:結合點擊熱圖(Heatmap)找出用戶盲區,作為假設檢定的基礎。例如,發現行動端導航選單的點擊集中於前三個選項,後續可針對此區域優化關鍵字布局。

最後,行動端測試需更頻繁迭代,因用戶習慣變化快速。建議每季至少執行一輪數位行銷相關測試,並透過試驗統計學方法持續優化,才能維持競爭力。

關於隨機對照試驗的專業插圖

電商應用案例

在2025年的電子商務戰場上,A/B測試已成為提升轉換率的標配工具。以台灣本土電商平台為例,當他們發現首頁的跳出率高達65%時,立刻啟動多變量測試來優化用戶體驗。透過隨機對照試驗,將流量分配給兩組不同設計的登陸頁面:控制組維持原有單一促銷橫幅,變異組則改為「分眾行銷」模組,根據用戶歷史行為顯示個性化商品推薦。經過兩週的灰度測試並運用雙母體假設檢定分析數據,發現變異組不僅降低跳出率至48%,客單價更提升22%,統計顯著性p值<0.01,證實新設計確實有效。

進階應用上,大型電商常結合試驗統計學來驗證複雜假設。例如某服飾品牌曾針對結帳流程進行AB測試,主要假設是「簡化付款步驟能減少棄單率」。他們設計了三種版本:原版(5步驟)、簡化版(3步驟)、極簡版(1頁式),並透過統計學方法確保每組樣本量足夠。結果顯示極簡版雖然轉換率最高,但客訴比例也增加15%,後續用數據分析發現原因是缺乏配送時間說明。這個案例說明數位行銷不能只追求單一指標,需綜合評估效能指標如NPS(淨推薦值)和退貨率。

中小型電商則可從小型測試著手。像是某家販售手工醬料的網站,原先產品頁的「加入購物車」按鈕是綠色,經假設檢定推測紅色更能刺激購買慾。他們用隨機實驗分配50%流量到紅色按鈕頁面,兩週後發現轉換率提升8.7%,且達到95%信賴區間。關鍵在於目標設定明確——這個測試只鎖定按鈕顏色,避免同時改動其他元素造成干擾。此外,他們也監測了關鍵字搜尋行為,發現紅色按鈕組的用戶更常使用「限量」「獨家」等詞彙,這類行銷策略洞察後續被應用在廣告文案優化。

對於促銷活動的網站優化,多變量測試尤其重要。2025年某3C電商在黑色星期五前,測試了四種不同的折扣展示方式:A組「直接顯示折後價」、B組「劃掉原價+紅字折扣」、C組「倒數計時器+限量標籤」、D組「會員專屬價」。透過實驗方法發現,B組在40歲以上客群轉換率最高,而C組對25-35歲族群特別有效。這促使他們採用動態UI,根據用戶畫像即時切換版型,最終整體GMV成長34%。這案例也凸顯用戶體驗必須因應分眾行銷需求,不能一刀切。

技術層面,現今電商平台普遍使用AI驅動的A/B測試工具,能自動判斷何時達到統計顯著性並停止實驗。例如當某次測試的轉換率差異持續一週未達標,系統會主動建議調整變因或擴大樣本。值得注意的是,2025年隱私權規範更嚴格,數據分析必須匿名化且符合GDPR,因此許多企業改採「分段式灰度測試」,先對1%用戶進行假設檢定,確認無負面影響再逐步放量。這種做法既能控制風險,又符合數位行銷的敏捷精神。

關於灰度測試的專業插圖

UI/UX優化策略

在2025年的電子商務戰場上,UI/UX優化策略已成為提升轉換率的核心關鍵。透過A/B測試(或稱AB測試),我們能科學化地驗證設計改動的實際效果,而不是憑直覺猜測。舉例來說,當你想優化結帳頁面的跳出率,可以設計兩組不同版本的按鈕(如顏色、大小、文案),並透過隨機對照試驗分配流量,觀察哪一組能帶來更高的完成率。這裡的關鍵在於統計顯著性——必須確保結果不是偶然產生,而是具有統計學上的可信度(通常要求p值<0.05)。

多變量測試(Multivariate Testing)則是更進階的手法,適合同時測試多個元素的組合效果。例如,電商網站的首頁可能同時調整「主視覺圖片」、「促銷文案」和「導航列位置」,這種方法能幫你找出最佳的整體配置,但需要更大的流量基礎才能達到試驗統計學要求的樣本數。2025年的工具如Google Optimize或VWO都已支援這類複雜測試,並能自動計算雙母體假設檢定的結果,讓非技術人員也能輕鬆解讀數據。

在實務操作上,分眾行銷策略常與UI/UX測試結合。比方說,對新用戶顯示引導性強的介面,而對回頭客則強調個人化推薦。這需要透過數據分析劃分受眾,並為每組設計專屬的變異組。值得注意的是,灰度測試(逐步釋出新版本)能降低風險,尤其適合重大改版。例如,先對5%用戶推出新介面,監控效能指標(如停留時間、點擊率)無異常後,再逐步擴大範圍。

最後,假設檢定的邏輯必須貫穿整個測試流程。從一開始的目標設定(如「將加入購物車率提升10%」),到選擇合適的實驗方法(A/B測試vs.多變量測試),再到分析時的統計學驗證,每一步都要嚴謹。實務上常見的錯誤包括:測試時間過短(未考慮週期性波動)、忽略控制組的基線數據,或過度解讀未達顯著性的結果。2025年領先的數位行銷團隊,已開始整合AI工具預測測試結果,但人工判讀仍是不可替代的關鍵。

關於假設檢定的專業插圖

多變量測試比較

多變量測試比較在數位行銷領域中,尤其是電子商務網站優化,扮演著關鍵角色。與傳統的A/B測試(僅比較單一變數)不同,多變量測試允許同時測試多個變數的組合效果,例如按鈕顏色、標題文案、圖片位置等,並透過統計學方法分析各變數對轉換率的影響。這種方法特別適合需要快速迭代的電商環境,因為它能更全面地評估用戶體驗的細微差異,並找出最佳組合。舉例來說,一家台灣的服飾電商可能在首頁同時測試「折扣資訊的呈現方式」(橫幅 vs. 彈窗)與「行動呼籲按鈕」(紅色 vs. 綠色),透過隨機對照試驗設計,確保數據的可靠性。

在執行多變量測試時,統計顯著性是核心考量。由於測試變數增加,所需的流量和時間也會大幅提升,因此建議先透過灰度測試在小範圍驗證假設,再擴大規模。例如,若想測試「商品頁面的布局」(單欄 vs. 雙欄)與「結帳流程步驟」(三步驟 vs. 五步驟),需確保每組樣本數足夠,避免因數據不足導致假設檢定失效。根據2025年最新的試驗統計學研究,建議每組至少收集1,000次有效互動,並使用雙母體假設檢定來比較不同組合的效能差異。此外,工具如Google Optimize或VWO能自動計算顯著性,降低人工分析門檻。

多變量測試的挑戰在於數據分析的複雜性。當變數交互作用時(例如按鈕顏色僅在特定文案下有效),需透過進階統計模型(如ANOVA)解讀。實務上,台灣電商常犯的錯誤是忽略控制組的設定,導致無法區分「自然流量波動」與「測試效果」。建議在設計實驗時,保留20%流量作為基準組,並監控跳出率等輔助指標。以分眾行銷為例,若針對「新客」與「回頭客」分別測試不同促銷訊息,需確保分群邏輯清晰,避免數據汙染。

最後,多變量測試的目標設定需與商業KPI緊密結合。除了轉換率,也可關注「平均訂單金額」或「用戶停留時間」等效能指標。例如,某3C電商發現「影片介紹+限時倒數計時器」的組合雖未提升轉換率,卻能增加15%的客單價,這類洞察需透過多維度分析才能發現。值得注意的是,2025年AI工具的普及讓變異組的設計更智慧化,系統能自動推薦高潛力組合,減少無效測試。然而,人工解讀與策略調整仍是不可替代的關鍵步驟。

關於統計學的專業插圖

統計顯著性判斷

在進行A/B測試或多變量測試時,統計顯著性判斷是決定測試結果是否可靠的關鍵步驟。簡單來說,如果你的電子商務網站進行了一場AB測試,比較新舊版本的轉換率差異,統計顯著性就是告訴你這個差異是不是「真的存在」,還是只是隨機波動造成的假象。對於數位行銷團隊來說,這一步絕對不能馬虎,否則可能會誤判測試結果,導致錯誤的行銷策略決策。

那麼,如何判斷統計顯著性呢?一般來說,我們會使用假設檢定的方法,常見的包括雙母體假設檢定(比如比較兩組的轉換率)。這裡的關鍵是設定一個顯著性水平(α值),通常是0.05,也就是說,如果計算出的p值小於0.05,我們就可以認為兩組的差異具有統計顯著性。舉個實際例子:假設你的電商網站進行了一次灰度測試,A組(控制組)的轉換率是3.5%,B組(變異組)是4.2%,這時候你需要透過統計工具(如Google Optimize或專用的試驗統計學軟體)計算p值。如果p值為0.03(<0.05),那就可以確定B組的表現確實比A組好,而不是偶然現象。

不過,統計顯著性只是第一步,你還需要考慮實際顯著性。比如,雖然B組的轉換率比A組高了0.7%,但這樣的差異是否足夠影響你的業務目標?如果這個提升帶來的收益無法cover測試成本,那即便統計上顯著,實際上也未必值得採用。這也是為什麼在分眾行銷或網站優化時,數據分析不能只看p值,還要結合業務場景和效能指標(如每用戶平均收益、客戶終身價值等)來綜合判斷。

另一個常見的誤區是過早停止測試。很多團隊在看到初步結果「看起來不錯」就急著下結論,但這樣可能會因為樣本量不足而誤判。舉例來說,如果你的電商網站跳出率在測試初期顯示B組較低,但隨著時間推移,數據又回歸到與A組相近的水平,這就說明初期結果可能只是隨機波動。因此,建議在進行隨機對照試驗時,一定要確保樣本量足夠(可以使用統計功效計算工具預估所需樣本),並且讓測試跑完完整的周期,避免「偽陽性」的風險。

對於複雜的多變量測試(比如同時測試首頁設計、按鈕顏色和促銷文案),統計顯著性的判斷會更加複雜,因為變數之間的交互作用可能影響最終結果。這時候,傳統的AB測試工具可能不夠用,需要借助更進階的試驗統計學方法,如多變量方差分析(MANOVA),來確保每個變數的影響都被準確評估。例如,某個電商網站發現同時修改標題和圖片後轉換率提升,但單獨測試時卻沒效果,這可能就是交互作用的典型例子。

最後,別忘了統計顯著性只是數據分析的一部分,還需要結合用戶體驗的定性反饋。比如,某次測試可能顯示新版本的跳出率降低了,統計上也顯著,但實際訪客卻抱怨導航變得更難用。這種情況下,盲目追求數字提升反而可能傷害品牌長期價值。因此,在網站優化過程中,建議將量化數據(如轉換率、跳出率)與質化洞察(如熱力圖、用戶訪談)結合,才能做出更全面的決策。

關於試驗統計學的專業插圖

行銷活動測試

行銷活動測試是提升數位行銷成效的關鍵環節,尤其在電子商務領域,透過科學化的A/B測試或多變量測試,能精準驗證不同行銷策略對轉換率的影響。舉例來說,當電商平台規劃年中促銷時,可以針對同一款商品設計兩種不同的廣告文案(如「限時5折」vs.「買一送一」),並隨機分配流量至控制組與變異組,透過統計學方法分析哪種方案更能降低跳出率並刺激購買。根據2025年最新行業報告,採用隨機對照試驗的企業平均可提升23%的廣告效益,關鍵在於嚴格控制變因(如受眾屬性、投放時段)並確保數據達到統計顯著性(通常要求p值<0.05)。

在實務操作上,分眾行銷常與AB測試結合運用。例如針對高客單價商品,可先透過用戶畫像篩選出「過去三個月有瀏覽紀錄但未下單」的族群,再對其測試不同折扣門檻(如「滿萬折千」vs.「免運+贈品」)。此時需注意試驗統計學中的雙母體假設檢定原則:若兩組樣本數差異過大(如控制組佔70%、變異組僅30%),可能導致數據分析失真。建議使用灰度測試工具(如Google Optimize或VWO)自動平衡流量,並設定明確的效能指標(如點擊率、加購次數),避免同時追蹤過多目標而模糊焦點。

進階的實驗方法還包括「動態內容測試」,特別適合電商網站的首頁輪播圖優化。假設某美妝品牌想測試夏季防曬產品的宣傳重點,可將同一版位設計為三種版本:A組強調「UV防護係數」、B組主打「防水抗汗」、C組結合明星代言影像。這種多變量測試能一次性驗證多個元素,但需確保每組流量足夠(至少1,000次曝光)以通過假設檢定。根據2025年Adobe的案例研究,搭配熱區圖(Heatmap)分析更能發現用戶注意力分佈,例如B組雖點擊率較高,但熱區集中在價格標籤而非產品功能,後續可調整排版強化核心賣點。

最後,行銷團隊必須建立標準化的目標設定流程。測試前應明確定義成功標準(如「註冊率提升15%」),並排除季節性干擾(避開農曆春節等旺季);測試中則需監控統計顯著性工具(如Bayesian Calculator),避免因短期波動誤判結果。舉例來說,某服飾品牌曾發現「免運門檻從$499降至$399」的方案在前三天顯著提升訂單量,但七天後轉換率回落至基準線,進一步分析才發現早期數據受忠誠會員集中消費影響。這類情境凸顯了網站優化不能只依賴單一指標,而需結合用戶體驗質化回饋(如問卷調查)進行交叉驗證。

關於雙母體假設檢定的專業插圖

持續優化循環

持續優化循環:讓A/B測試成為電商成長的引擎

在數位行銷領域,持續優化循環是提升轉換率與用戶體驗的核心策略。尤其對電子商務網站來說,單次A/B測試的結果只是起點,真正的價值在於透過數據分析建立長期迭代的流程。舉例來說,當你測試「結帳按鈕顏色」並發現紅色比藍色點擊率高10%時,下一步不該是滿足於現狀,而要思考:「這個結果是否達到統計顯著性?能否進一步結合多變量測試優化整體頁面?」。這種循環需要嚴謹的試驗統計學基礎,例如透過雙母體假設檢定確認數據差異的真實性,而非隨機波動。

如何設計有效的優化循環?

1. 目標設定與假設檢定:每次測試前,明確定義效能指標(如轉換率、跳出率),並提出可驗證的假設(例如「縮短表單欄位能減少用戶放棄率」)。

2. 分階段實驗:先以灰度測試小規模驗證,再逐步擴大流量。例如某電商發現「免運費門檻從999元降至799元」能提升5%訂單量,但需同步監控利潤變化。

3. 多變量測試進階應用:當單一變數優化遇到瓶頸,可導入多變量測試(MVT),同時調整標題、圖片、CTA按鈕等元素,找出最佳組合。例如某服飾品牌透過MVT發現「明星代言圖+限時倒數計時器」能提升20%加購率。

避免常見陷阱

- 統計顯著性誤判:數據未達95%信賴區間就倉促決策,可能導致誤判。例如測試兩週後A版轉換率「看似」較高,但實際因樣本不足而未達顯著。

- 忽略分眾行銷差異:同一版本對新客與回頭客效果可能截然不同。建議搭配分眾行銷策略,例如對高客單價用戶展示專屬優惠,而非統一測試。

- 過度依賴工具:工具能簡化隨機對照試驗流程,但若未釐清業務目標(如品牌調性 vs. 短期轉換),可能優化出「高點擊卻低忠誠度」的版面。

實務案例:電商首頁的迭代過程

以2025年台灣某美妝電商為例,其透過持續優化循環將跳出率從65%降至42%。關鍵步驟包括:

1. 初期以A/B測試比較「輪播Banner vs. 靜態主圖」,發現靜態圖提升停留時間15%。

2. 進階測試「產品分類導航列」位置(頂部 vs. 側邊欄),結合熱圖分析發現頂部導航更符合用戶習慣。

3. 最後導入多變量測試,將「會員積分提示」「促銷倒數」「用戶評價模組」三元素組合測試,找出最佳佈局。

數據驅動的文化建立

要落實持續優化,團隊需培養「假設→驗證→學習」的思維:

- 每季度回顧測試結果,將成功經驗標準化(如「所有產品頁需包含影片示範」)。

- 建立效能指標儀表板,即時監控轉換率、跳出率等關鍵數據。

- 鼓勵跨部門協作,例如行銷團隊提出文案假設,工程團隊協助埋點追蹤。

在快速變化的數位行銷環境中,唯有將AB測試制度化,才能讓每一次調整都累積成長動能。別忘了,就連全球龍頭電商至今仍在每日運行上千次測試——你的優化循環,開始轉動了嗎?